咱们用来聊聊一种叫做“循环神经网络”(Recurrent Neural Networks,简称RNN)的厉害的家伙。它就像我们人类一样,能够记住之前发生的事情,并且在理解现在的事情时,会考虑到过去的经验。

想象一下:你正在读一本书

你读第一个字的时候,大脑就开始理解这个字的意思。当你读到第二个字的时候,你的大脑不仅仅理解这个字本身,还会结合你刚刚读过的第一个字,来理解这两个字合在一起的意思。当你读到一句话、一段话甚至整本书的时候,你的大脑一直在记住之前读过的内容,并且用这些记忆来帮助你理解现在正在读的东西。

循环神经网络(RNN)的工作方式就有点像我们的大脑在阅读时的过程。它被设计用来处理像文本、语音、视频片段或者股票价格这样有“顺序”的数据。

传统的神经网络的局限性

在我们深入了解RNN之前,先简单说说传统的神经网络(也叫前馈神经网络)。你可以把它们想象成一个工厂的流水线,数据像产品一样从一个环节流向下一个环节,每个环节只负责处理当前收到的“产品”,处理完就交给下一个环节,不会回头看之前发生了什么。

这种结构对于处理像图片(每个像素点是独立的)或者一些简单的分类问题是足够的。但是,对于像我们前面说的阅读理解,或者预测明天的天气(今天的天气肯定有影响),这种“一次性”处理的方式就显得力不从心了。因为它们没有“记忆”功能,无法利用之前的信息。

RNN的出现:让神经网络有了“记忆”

RNN的厉害之处就在于它引入了“循环”的概念,让信息可以在网络内部“流动”和“记住”。你可以把它想象成在流水线上增加了一个“记忆模块”,这个模块可以记录之前处理过的信息,并且在处理当前信息的时候,把之前的“记忆”也考虑进来。

RNN的基本结构:像一个带着“小抄”的工人

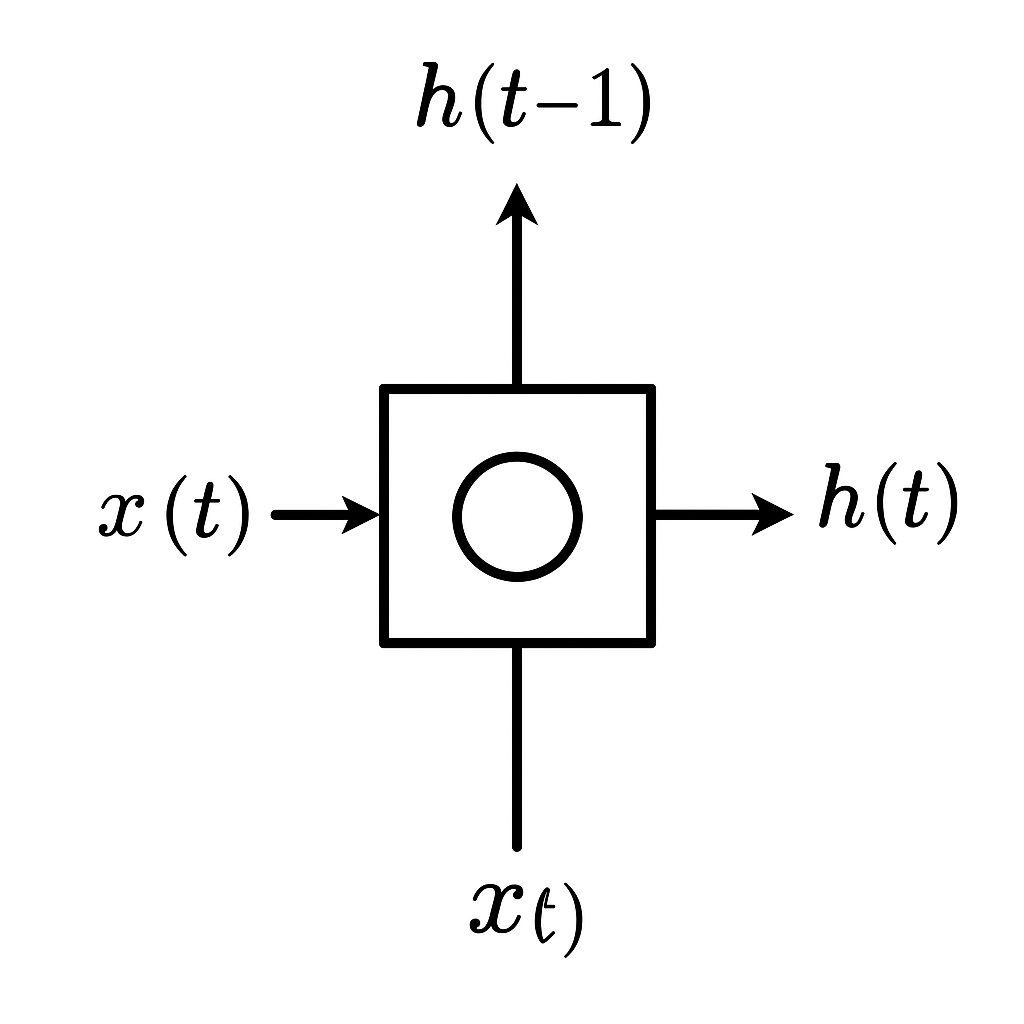

一个最基本的RNN单元可以这样理解:

- 输入 (Input): 就像你正在读的当前这个字或者当前这个时间点的股票价格。

- 隐藏状态 (Hidden State): 这就是RNN的“记忆”或者“小抄”。它会记录之前看到的信息,并且在处理当前输入的时候,把这个“小抄”拿出来参考。每当RNN处理一个新的输入,它都会更新这个“隐藏状态”。

- 输出 (Output): 这是RNN根据当前的输入和之前的“记忆”给出的结果。比如,如果你让RNN读一句话,它的输出可能是预测下一个词是什么。

关键在于“循环”

最核心的地方在于,当RNN处理完一个输入后,它会把当前的“隐藏状态”传递到下一个时间步(也就是处理下一个输入的时候)。这样,下一个时间步的RNN单元在处理新的输入时,就能够利用到上一个时间步的“记忆”了。这个过程就像一个循环,信息在时间上不断地传递和更新。

用更形象的例子来理解“隐藏状态”

想象你正在听一个人说话,他说了好几句话。你的大脑会记住他之前说的一些关键词或者主要意思,这样当你听到他后面的话时,你才能更好地理解他整体要表达什么。这里的“记住的关键词或者主要意思”就可以类比成RNN的“隐藏状态”。

RNN的“展开”

为了更好地理解RNN的工作方式,我们通常会把它“展开”来看。假设你有一个长度为5的句子需要处理,你可以想象成有5个RNN单元串联在一起。

- 第一个RNN单元处理句子的第一个词,生成一个隐藏状态,并传递给第二个RNN单元。

- 第二个RNN单元处理句子的第二个词,它不仅接收到第二个词作为输入,还接收到第一个RNN单元传递过来的隐藏状态。它会结合这两部分信息生成新的隐藏状态,并传递给第三个RNN单元。

- 以此类推,直到最后一个RNN单元处理完句子的最后一个词。

在这个“展开”的过程中,每个RNN单元都共享相同的“规则”(也就是相同的权重和偏置),这使得模型可以在不同时间步上学习到通用的模式。

RNN的种类:不止一种“记忆”方式

虽然上面介绍的是最基本的RNN结构,但为了解决一些实际问题中遇到的挑战,研究人员还提出了更复杂的RNN变体,其中最著名的就是:

- 长短期记忆网络 (Long Short-Term Memory Networks, LSTM): LSTM就像一个更聪明的“记忆”模块。它不仅能够记住信息,还能够决定哪些信息应该被记住更长时间(长期记忆),哪些信息可以暂时忘记(短期记忆)。这使得LSTM在处理长序列数据时表现得更好,例如长篇文章的理解或者长时间的视频分析。LSTM通过引入一些特殊的“门”结构(输入门、遗忘门、输出门)来实现这种更精细的记忆控制。

- 门控循环单元 (Gated Recurrent Units, GRUs): GRU是LSTM的一种简化版本,它把LSTM中的一些门合并了,结构更简单,但性能在很多任务上与LSTM相当。GRU也有更新门和重置门,用来控制信息的流动和记忆的更新。

RNN的应用场景:无处不在的“顺序”数据

由于RNN能够处理序列数据,因此在很多领域都有广泛的应用:

- 自然语言处理 (Natural Language Processing, NLP):

- 文本生成: 比如写诗、生成新闻标题、创作剧本。

- 机器翻译: 将一种语言的文本翻译成另一种语言。

- 情感分析: 判断一段文本表达的情绪是积极的、消极的还是中性的。

- 问答系统: 根据用户提出的问题,从文本中找到答案。

- 语音识别: 将语音转换成文字。

- 文本分类: 将文本划分到不同的类别,比如垃圾邮件过滤。

- 时间序列预测:

- 股票价格预测: 虽然难度很大,但RNN可以尝试学习历史价格的模式来预测未来价格的走势。

- 天气预报: 利用过去的天气数据预测未来的天气情况。

- 交通流量预测: 预测未来一段时间内道路的拥堵情况。

- 视频处理:

- 动作识别: 识别视频中人物或物体的动作。

- 视频描述: 自动生成视频内容的文字描述。

- 音乐生成: 让计算机创作音乐。

RNN的优势和局限性

优势:

- 能够处理序列数据: 这是RNN最核心的优势。

- 能够记住之前的状态: 通过隐藏状态,RNN可以利用历史信息。

- 模型参数共享: 在不同的时间步上使用相同的权重,降低了模型的复杂度。

局限性:

- 梯度消失和梯度爆炸问题: 这是传统RNN在处理长序列时遇到的主要挑战。由于信息在时间上的传递过程中会不断进行矩阵乘法,可能会导致梯度变得非常小(消失)或者非常大(爆炸),从而影响模型的训练效果。这也是LSTM和GRU被提出的重要原因之一,它们通过引入门机制在一定程度上缓解了这个问题。

- 难以捕捉长期依赖: 虽然LSTM和GRU有所改进,但对于非常长的序列,仍然可能难以有效地记住很久以前的信息。

- 计算成本相对较高: 特别是对于长序列,RNN的计算量会比较大。

- 难以并行化: 由于序列的依赖性,RNN在处理一个时间步的输入时,需要等待前一个时间步的计算结果,这限制了其并行计算的能力。

总结一下

循环神经网络(RNN)是一种专门用来处理序列数据的神经网络。它通过引入“隐藏状态”来实现记忆功能,使得网络在处理当前信息时能够考虑到之前的信息。RNN的基本结构就像一个带着“小抄”的工人,每一步都会参考之前的“记忆”并更新它。为了解决传统RNN在处理长序列时遇到的问题,研究人员提出了更复杂的变体,如LSTM和GRU,它们通过引入门机制来更好地控制信息的流动和记忆。RNN在自然语言处理、时间序列预测、视频处理和音乐生成等领域都有广泛的应用。虽然RNN有一些局限性,但它仍然是处理序列数据的重要工具。。