深入理解池化层:计算机视觉的关键组成部分

在深度学习和计算机视觉的世界中,卷积神经网络(CNN)是一种非常流行的架构,它能够很好地处理图像任务。而池化层(Pooling Layer)作为 CNN 的重要组成部分,起到了至关重要的作用。本文将详细介绍池化层的概念、作用、不同类型及其具体应用,并通过深入讲解,让你对池化层有一个全面的理解。

1. 什么是池化层?

池化层(Pooling Layer)是卷积神经网络中的一种特殊层,它的主要功能是对特征图进行降维,同时保留最重要的信息。简单来说,它就像一个“信息压缩器”,能让数据在减少计算量的同时,仍然保持图像的关键特征。

当我们使用卷积层提取图像特征时,输出的特征图通常会很大。如果不对数据进行处理,计算量会随着网络的加深而急剧增加,导致计算资源的消耗变得难以承受。这时候,池化层就能发挥作用,通过减少数据维度,提高计算效率,同时保持主要特征。

2. 池化层的作用

池化层在 CNN 中主要起到以下几个作用:

2.1 降低计算成本

由于池化层会缩小特征图的尺寸,后续的计算量会减少很多。比如,一张 256×256 的图片,经过池化后可能会缩小到 64×64,从而减少 16 倍的计算量。

2.2 降低过拟合风险

池化层会减少模型的参数数量,使模型更加稳健,不容易陷入过拟合的问题。过拟合通常发生在训练数据过于复杂,使得模型只对训练数据有效,而无法泛化到新的数据。

2.3 提高特征的平移不变性

池化可以让 CNN 在图像发生小幅度的平移时,仍然能够保持相似的特征提取能力。这样即使物体的位置稍微发生变化,网络依然可以识别它们。

3. 池化层的类型

池化层有几种常见的类型,每种类型都有其适用场景。

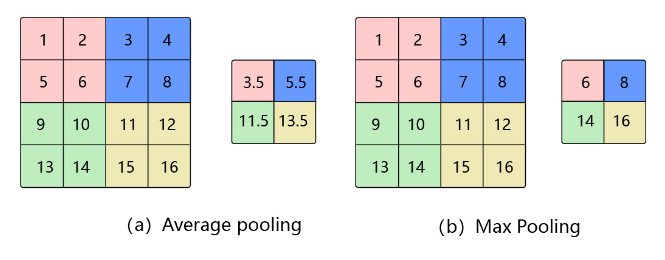

3.1 最大池化(Max Pooling)

最大池化是最常用的一种方法,它的原理非常简单:在每个池化窗口(通常是 2×2 或 3×3)中取最大值作为输出。

例如,假设我们有一个 2×2 的窗口,包含数值如下:1 3 4 2

最大池化的结果是 4,因为它是窗口内的最大值。

优点:

- 能够保留最显著的特征,提高模型的鲁棒性。

- 计算量较低,能够加速训练过程。

缺点:

- 可能会丢失一些细节信息。

3.2 平均池化(Average Pooling)

平均池化的计算方式与最大池化类似,不同之处在于,它不是取最大值,而是取窗口内所有数值的平均值。

例如,还是上述 2×2 窗口:1 3 4 2

平均池化的结果是 (1+3+4+2)/4 = 2.5。

优点:

- 由于计算的是平均值,输出更加平滑,能够保留整体信息。

- 适用于对背景信息要求较高的任务,如医学图像分析。

缺点:

- 可能会导致特征不够显著,降低模型的识别能力。

3.3 全局池化(Global Pooling)

全局池化是一种特殊的池化方式,它会在整个特征图上执行池化操作,最终得到一个单一值。

全局最大池化(Global Max Pooling)会取整个特征图的最大值,而全局平均池化(Global Average Pooling)会计算整个特征图的平均值。

应用场景:

- 在深度神经网络的最后一层,全局平均池化常用于代替全连接层,以减少参数数量,提高泛化能力。

4. 池化层的具体实现方式

4.1 代码示例(PyTorch)

在 PyTorch 中,我们可以使用 torch.nn.MaxPool2d 或 torch.nn.AvgPool2d 来实现池化层。

例如:import torch import torch.nn as nn # 创建最大池化层 (2x2 窗口,步长 2) maxpool = nn.MaxPool2d(kernel_size=2, stride=2) # 输入特征图 (1,1,4,4) 代表批量大小1,通道数1,4x4的图像 input_tensor = torch.tensor([[[[1, 3, 2, 1], [4, 6, 5, 2], [3, 2, 1, 7], [8, 9, 4, 6]]]], dtype=torch.float32) # 进行最大池化 output_tensor = maxpool(input_tensor) print(output_tensor)

4.2 TensorFlow/Keras 代码示例

在 TensorFlow/Keras 中,我们可以使用 tf.keras.layers.MaxPooling2D 实现池化层,

例如:import tensorflow as tf from tensorflow.keras.layers import MaxPooling2D # 创建最大池化层 (2x2 窗口,步长 2) pooling_layer = MaxPooling2D(pool_size=(2,2), strides=2)

5. 池化层的优化与未来发展

尽管池化层在深度学习中非常重要,但近年来也出现了一些针对池化的改进方法,如:

- 自适应池化(Adaptive Pooling):允许输出特征图大小可变。

- 空间金字塔池化(SPP):在目标检测任务中广泛使用。

- 反池化(Unpooling):用于恢复池化过程中丢失的信息,在生成模型(如 GAN 和自动编码器)中很常见。

6. 结论

池化层是卷积神经网络中的重要组成部分,它能够有效降低计算量,提高模型的稳定性,同时增强模型对平移变化的鲁棒性。不同类型的池化方法适用于不同的任务,我们在使用 CNN 进行图像处理时,应该根据具体情况选择合适的池化方式。

Qzywudi

好好好