什么是过拟合?

在机器学习和深度学习的世界里,过拟合(overfitting)是一个非常常见但又令人头疼的问题。它指的是模型在训练数据上表现得非常好,甚至完美,但在新数据(测试数据)上的表现却很差。换句话说,模型”学得太好”了,以至于它把训练数据中的噪声和细节当成了真正的规律,而这些噪声并不具有普遍性。

想象一下,你在准备一个考试,你把所有练习题的答案都背了下来。考试的时候,碰到的题目稍微变了个样子,但你的答题方式却完全依赖于你背过的答案。这种情况就类似于过拟合。

为什么会发生过拟合?

过拟合的产生主要有以下几个原因:

- 模型太复杂 如果模型有太多的参数,比如过多的神经网络层和神经元,它就有能力去”记住”训练数据中的每一个细节,而不是学到数据背后的真实规律。

- 数据量不足 当训练数据太少时,模型无法接触到足够多的样本去理解数据的多样性。这时,模型只能死记硬背训练数据。

- 数据噪声过多 如果训练数据中有很多错误数据或异常值,模型可能会错误地将这些噪声当作规律学进去。

- 没有正则化 在模型训练过程中,如果没有使用适当的正则化方法(比如L1、L2正则化或dropout),模型更容易过拟合。

过拟合的表现

- 训练误差很低,但测试误差很高 如果模型在训练数据上的表现特别好,但在测试数据上却表现糟糕,很可能就是过拟合了。

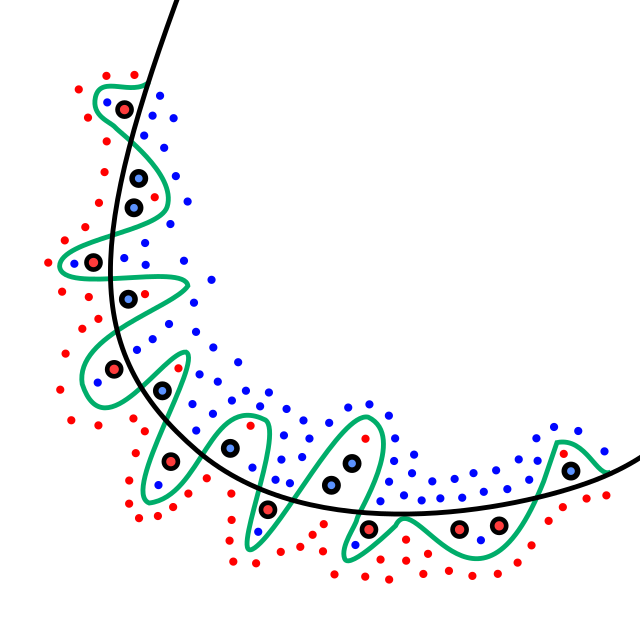

- 学习曲线的分离 当我们绘制训练误差和验证误差的曲线时,训练误差会随着时间下降得非常快,而验证误差在某个点后开始上升。

- 对新数据的预测不准确 过拟合的模型在面对从未见过的新数据时,预测的准确率往往很低。

如何解决过拟合?

- 增加数据量 更多的训练数据可以帮助模型更好地捕捉数据的真实分布,而不是死记硬背现有的数据。这种方法虽然有效,但在实际中并不总是容易实现。

- 使用数据增强 数据增强是通过对现有数据进行变换(如旋转、翻转、缩放等)来增加样本量,从而提高模型的泛化能力。

- 减少模型复杂度 通过减少神经网络的层数、神经元的数量或限制模型的参数,可以降低模型的复杂度,减少过拟合的风险。

- 正则化

- L1和L2正则化:通过在损失函数中加入一个与权重相关的惩罚项,限制权重的大小,从而减少模型过拟合。

- Dropout:在每次训练时随机丢弃一部分神经元,让模型不会过于依赖某些特定的神经元。

- 早停(Early Stopping) 在训练过程中,当验证集的误差不再下降时提前停止训练,防止模型过度拟合训练数据。

- 交叉验证 使用交叉验证可以帮助我们评估模型的泛化能力,从而选择更合适的超参数和模型结构。

- 简化特征 如果输入数据中有太多无关的特征,模型可能会把注意力分散在无用的特征上。通过特征选择或降维技术(如PCA),我们可以减少特征数量。

一个直观的例子

假设你是一个水果摊老板,你想训练一个模型来区分苹果和橘子。你用了一些水果图片作为训练数据。

- 如果模型太简单,它可能只会关注水果的大小来分类,比如大的是苹果,小的是橘子。但这样一来,如果碰到一个小苹果或大橘子,它就会分错类。这是欠拟合。

- 如果模型太复杂,它可能会记住训练数据中每张水果图片的细节,比如苹果上的某个斑点或橘子上的某条纹理。当给它一张新图片时,它可能因为斑点或纹理稍有不同而判断错误。这就是过拟合。

- 最理想的情况是,模型学会关注普遍的规律,比如苹果是红色或绿色的,而橘子是橙色的。

总结

过拟合是机器学习中常见的问题,但通过增加数据量、调整模型复杂度、使用正则化等方法,我们可以有效地缓解这一问题。最重要的是,训练模型时要找到一个平衡点,让模型既不过于简单,也不过于复杂,从而具备良好的泛化能力。